Tech

Le Travel Tripod de Peak Design arrive sur Kickstarter

Peak Design lance aujourd’hui sa neuvième campagne Kickstarter avec un produit dont les photographes baroudeurs se languissaient : un trépied photo léger, compact et hyper polyvalent. Le Travel Tripod.

Switch d’un iPad Mini vers un iPad 2018 (6e génération)

Apple User depuis une grosse dizaine d’année, je n’ai cédé aux sirènes de l’iPad qu’en 2012, à l’annonce de l’iPad Mini. Après plus de 5 ans de bons et loyaux services, et beaucoup d’hésitations, j’ai finalement remplacé ce petit compagnon…

« Apprendre ne sert à rien, c’est dangereux et ça rend idiot »

Cet article vient en réaction à l’interview, surréaliste de mon point de vue, qu’a donné Nicolas Sadirac, DG de l’école 42 cofondée avec Xavier Niel, dans laquelle il postule qu’apprendre ne sert à rien. L’histoire retiendra peut-être que le premier…

#AppleEvent2017 : Bilan du Keynote

Il est à peine 21h.Le flux video vient de se couper.Tim Cook, comme d’habitude en ces occasions, vient d’inviter les journalistes présents sur place à aller prendre en main les nouveaux appareils présentés au cours des deux dernières heures :…

Régions : « My bretzel is Rich(ert) »

Hier avait lieu la séance inaugurale des nouveaux conseils régionaux issus des élections de décembre dernier. Les nouveaux présidents de régions ont été élus. Sans suspens. Discours convenus, communication contrôlée, clichés claquants classiques… Bref, la routine. La routine, vraiment ?…

Le chocoblast en entreprise

Non, le chocoblast ne concerne pas des batailles rangées au pistolet à chocolat ou la critique d’une obscure série Z nippone dont le héros serait un robot armé d’un canon en chocolat… Non. Le chocoblast, tel que le définit si…

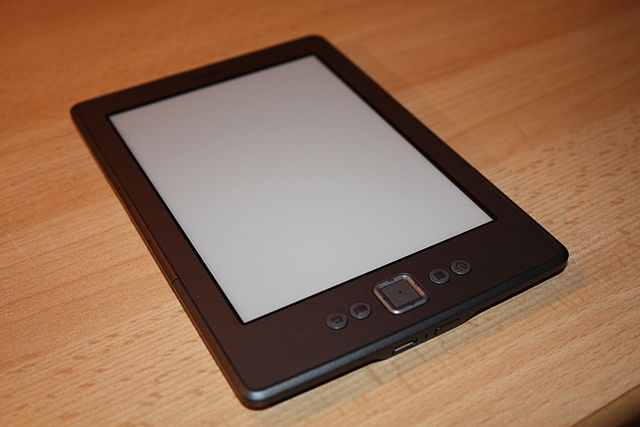

J’ai testé pour vous : 10 jours avec le Kindle d’Amazon

Depuis le 13 octobre dernier, je suis l’heureux propriétaire d’un Kindle version 4 d’Amazon. N’ayant jamais franchi le pas avant sa mise à disposition en France, du fait principalement de l’inexistence d’offre sérieuse en livres français dans le Kindle store à l’époque,…

Un Huis-clos pas très net

Je re-publie cette note, désespérément trop longue au goût de certains journalistes (mais elle n’a pas vocation a être journalistique), plus d’un an après, parce qu’elle n’avait pas déplue, et que, malgré son ancienneté, j’en reste assez fier ! C’est…

Quand Lille explose c’est le net qui s’enflamme

Voilà ce qu’il fallait redouter. Alors qu’il s’agissait d’une information tout à fait banale, à savoir une forte détonation ressentie à Lille et dans sa région et relayée via Twitter, Facebook et quelques forums, par certains riverains de la région,…

Quand iPapy doit justifier son évangile

Ça n’aura échappé à personne. Ce qui marque ce début d’année 2010 ce n’est pas le WEF de Davos ou les quelques performances sportives, exceptionnelles, de l’équipe de France de Handball ou de Roger Federer, mais bien le lancement, quasi…